文章目录[隐藏]

SambaNova Systems和Gradio宣布了一项新的集成,使开发者能够通过几行代码访问最快速的AI推断平台之一。这次合作旨在使高性能AI模型更加易于获取,并加快开发者和企业对AI的采用。

Gradio ML增长主管Ahsen Khaliq的评价

Gradio的ML增长主管Ahsen Khaliq在接受VentureBeat采访时表示:“这次集成使开发者能够轻松地从SambaNova游乐场复制代码,并使用几行代码在几分钟内运行一个Gradio网络应用程序。” “借助SambaNova Cloud的超级快速推断,这意味着无论是开发者还是最终用户都能获得极佳的用户体验。”

SambaNova-Gradio集成的特点

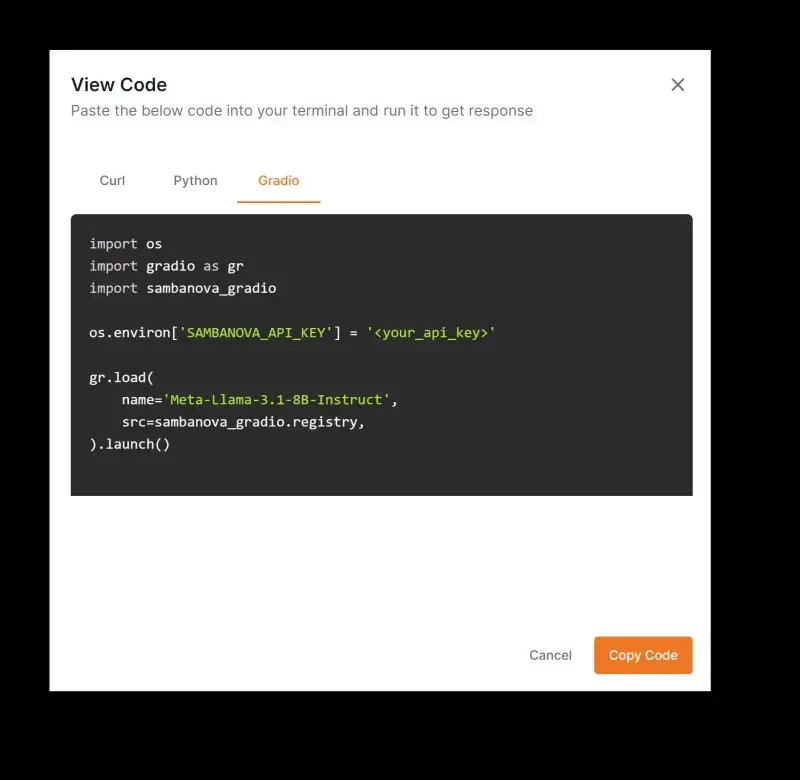

SambaNova-Gradio集成允许用户使用Gradio的gr.load()函数创建由SambaNova的高速AI模型提供支持的Web应用程序。开发者现在可以快速生成一个与SambaNova模型相连的聊天界面,使高级AI系统的工作变得更加容易。

超越GPU:数据流架构在AI处理中的崛起

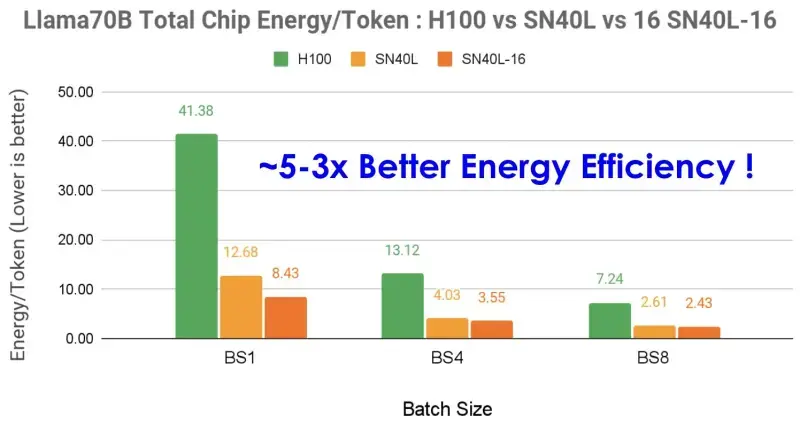

由软银和黑岩支持的硅谷初创公司SambaNova在AI硬件领域以其数据流架构芯片引起了轰动。这些芯片旨在超越传统的GPU,用于AI工作负载,该公司声称提供“世界上最快的AI推断服务”。

SambaNova的平台可以以全精度运行Meta的Llama 3.1 405B模型,每秒132个令牌,这个速度对于希望大规模部署AI的企业来说尤为重要。

随着AI基础设施市场的升温,SambaNova、Groq和Cerebras等初创公司正在挑战英伟达在AI芯片领域的霸主地位。这些新进入者专注于推断——AI的生产阶段,模型基于其训练生成输出——预计这个市场将比模型训练更大。

从代码到云:AI应用程序开发的简化

对于开发者来说,SambaNova-Gradio集成提供了一个无缝的切入点,可以尝试高性能AI。用户可以访问SambaNova的免费层,将任何支持的模式包装成一个Web应用程序,并在几分钟内自行托管。这种易用性反映了最近旨在简化AI应用程序开发的行业趋势。

该集成目前支持Meta的Llama 3.1系列模型,包括庞大的405B参数版本。SambaNova声称是唯一一个以全16位精度高速运行这个模型的提供商,这种精确度对于需要高准确性的应用来说尤其有吸引力,例如在医疗保健或金融服务中。

AI的隐藏成本:速度、规模和可持续性的权衡

尽管集成使高性能AI更易于获取,但对于AI芯片竞争的长期影响仍有疑问。随着公司竞相提供更快的处理速度,对能源使用、可扩展性和环境影响的担忧也在增加。

虽然关注每秒令牌数等原始性能指标很重要,但可能会掩盖AI部署中的其他关键因素。随着企业将AI整合到其运营中,他们需要在速度与可持续性之间取得平衡,考虑总拥有成本,包括能源消耗和冷却要求。

此外,支持这些新AI芯片的软件生态系统将显著影响它们的采用。尽管SambaNova和其他公司提供强大的硬件,但英伟达的CUDA生态系统凭借其广泛的最优化库和工具保持了优势,许多AI开发者已经非常熟悉这些工具。

市场前景与挑战

随着AI基础设施市场的不断发展,像SambaNova-Gradio这样的集成可能会变得越来越普遍。这些合作伙伴关系有可能在一场承诺改变各行各业的技术领域中促进创新和竞争。然而,真正的考验将在于这些技术如何转化为现实世界的应用,以及它们是否能够实现为所有人提供更易于获取、更高效、更强大的AI的承诺。(来源)