文章目录[隐藏]

在 Stable Diffusion XL 0.9 版本泄露半个月后,Stability AI 终于在北京时间7月27日正式发布Stable Diffusion XL 首个正式版 1.0,相对于0.9版本,SDXL 1.0能生成更加鲜明准确的色彩,在对比度、光线和阴影方面做了增强,可生成100万像素的图像(1024 x 1024),这直接对标的就是Midjourney和Adobe Firefly,官方除了提供消费级应用 ClipDrop 和 DreamStudio,Stable Diffusion XL 1.0 版本也已经在 GitHub 上以开源形式发布,目前已经可以在本地电脑上运行,今天就一起来看看吧!

[t-success icon='']Stable Diffusion XL 1.0(SDXL 1.0)[/t-success]

Stable Diffusion XL(SDXL)1.0的基础模型拥有35亿个参数,模型组合管线则高达66亿个参数,其优化器(refiner)能为基础模型产出图片加入更准确的色彩、更高对比及更多细节,Stability API也强化微调、定制化功能,让用户可用最少5张图片就能针对特定人士、产品或物件定制图片。Stability AI表示新功能目前正在和几家合作伙伴测试,未来几周内会正式释出。此外,Stability AI也宣布与亚马逊AWS达成合作,SDXL 1.0已经登上AWS AI模型服务Amazon Bedrock,而AWS机器学习演算法中心Amazon SageMaker JumpStart也将加入SDXL 1.0。

官方说明文章:https://stability.ai/blog/stable-diffusion-sdxl-1-announcement

[t-success icon='']如何使用SDXL 1.0?[/t-success]

对于如何使用SDXL 1.0,官方也已经提供了多种方法,如果你电脑里的显卡不好,可以使用官方提供的服务ClipDrop 和 DreamStudio,或者亚马逊的云服务,电脑配置好那就可以下载官方开源的模型,在本地运行:

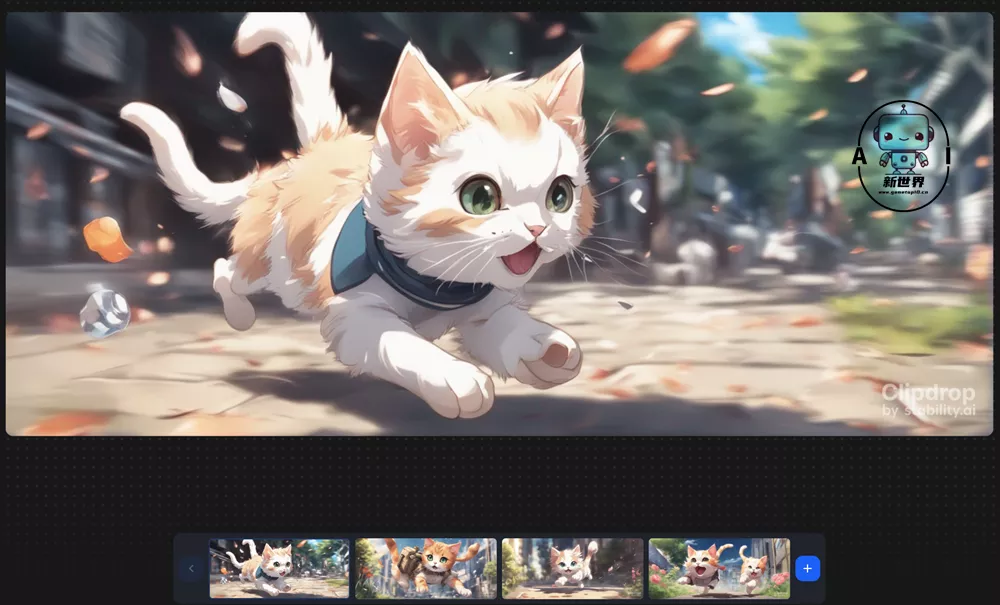

1、ClipDro

ClipDrop是Stability AI旗下的AI工具,目前提供了 AI 去背景、AI 调光、无损放大、AI 去水印等,自然也提供了SDXL服务,可以使用更短的提示语与选择图片风格、尺寸进行生成图片,无需注册账号即可使用,但需要排队,注册账号后排队时间会缩短。(具体可参考:Stability AI旗下的AI图片编辑工具「ClipDro」)

👇没有写反向提示词,生成的猫咪图

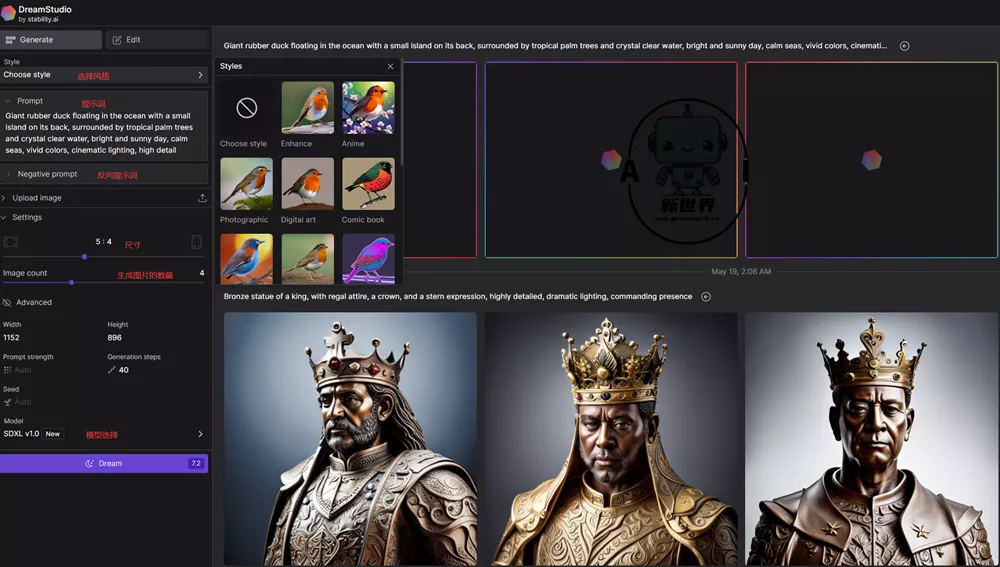

2、DreamStudio

DreamStudio是Stability AI 旗下官方版 Stable Diffusion,用户注册后就可以免费试用,免费用户可以生成约 110 张图片,不过使用SDXL 1.0模型需要的点数较高,如果小编生成4张图就需要7.2个点数,如果再使用就需要进行充值。(相关:Stability AI推出DreamStudio开源版本StableStudio)

DreamStudio 官方网址:https://dreamstudio.ai/generate

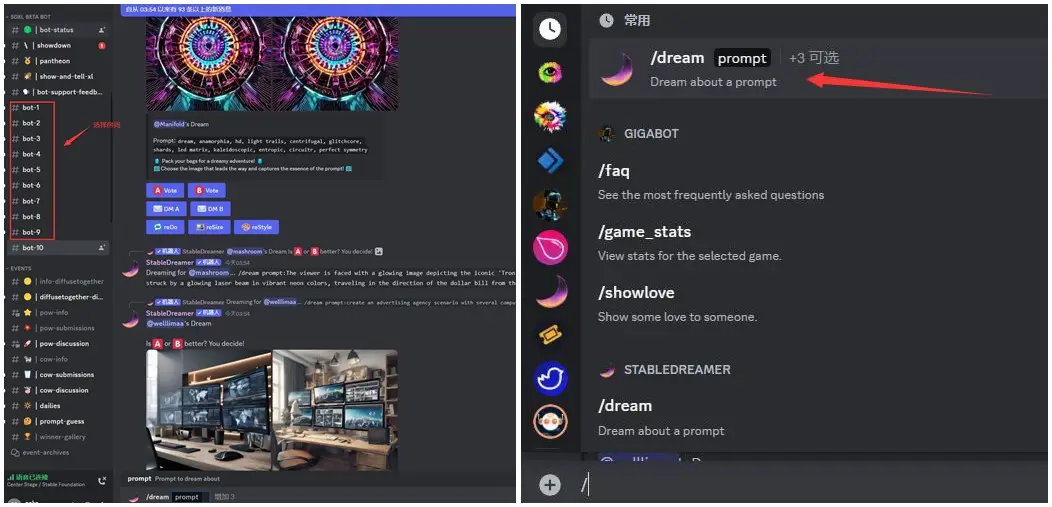

3、Stable Foundation Discord

Stability AI 已经在 Discord 上线了 SDXL 1.0 模型供大家免费体验,用户可以像在 Midjourney 一样直接输入 prompt 生图,不用再本地部署模型,操作门槛大大降低。(具体可参考:SDXL 1.0 模型登录Discord开启公测,你还不来试试!)

4、API、 AWS Sagemaker 和 AWS Bedrock

Stability AI也像OpenAI一样提供了Stable Diffusion XL系列的API,不过这一项主要针对开发者,对于普通用户来说并不实用;如果你的电脑配置不高,可以在亚马逊的AWS上使用SDXL 1.0。

Stability AI Platform:https://platform.stability.ai

AWS Sagemaker:https://docs.aws.amazon.com/sagemaker/latest/dg/studio-jumpstart.html

AWS Bedrock:https://aws.amazon.com/bedrock

5、本地安装使用SDXL 1.0

Stable Diffusion XL 1.0 版本也已经在 GitHub 上以开源形式发布,大家可以可以直接在GitHub上下载安装,不过小编相信应该没有多少人会直接用官方的原版,毕竟命令行界面不是每个人都可以适应的,目前已经有非常多第三方带UI界面的程序可以使用,比如Stable Diffusion web UI、ComfyUI 和InvokeAI,而在这些第三方程序中使用SDXL 1.0就需要下载模型和vae。

👇需要从开源地址内通过链接下载以下文件,包括两个模型和一个vae,还有一个可有可无的lora,如果你无法下载,小编已经下载后放入网盘,在文末会告诉你如何下载

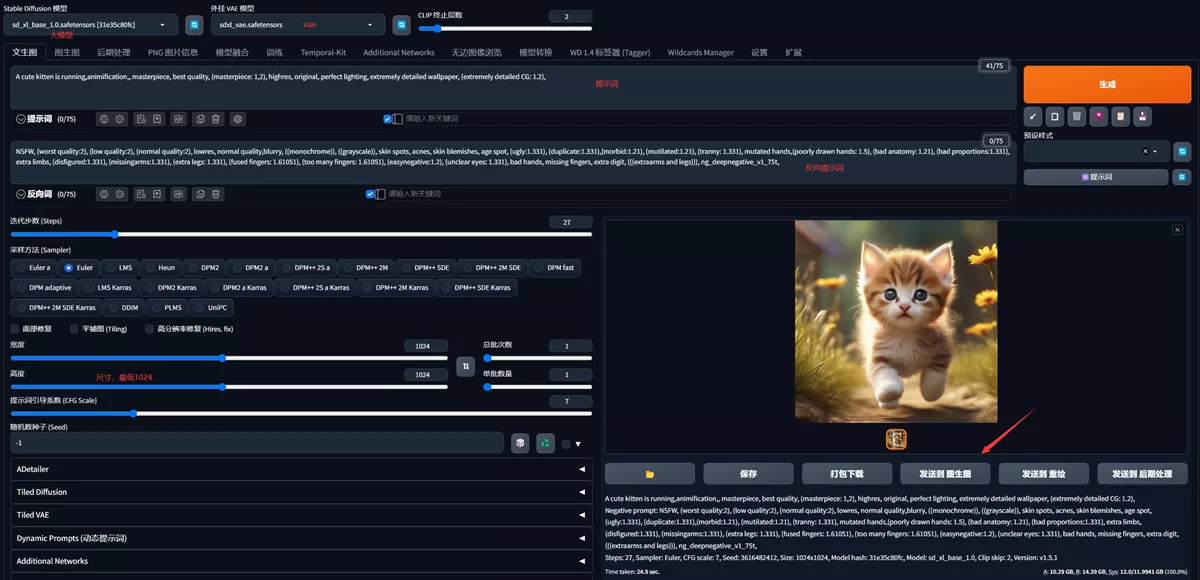

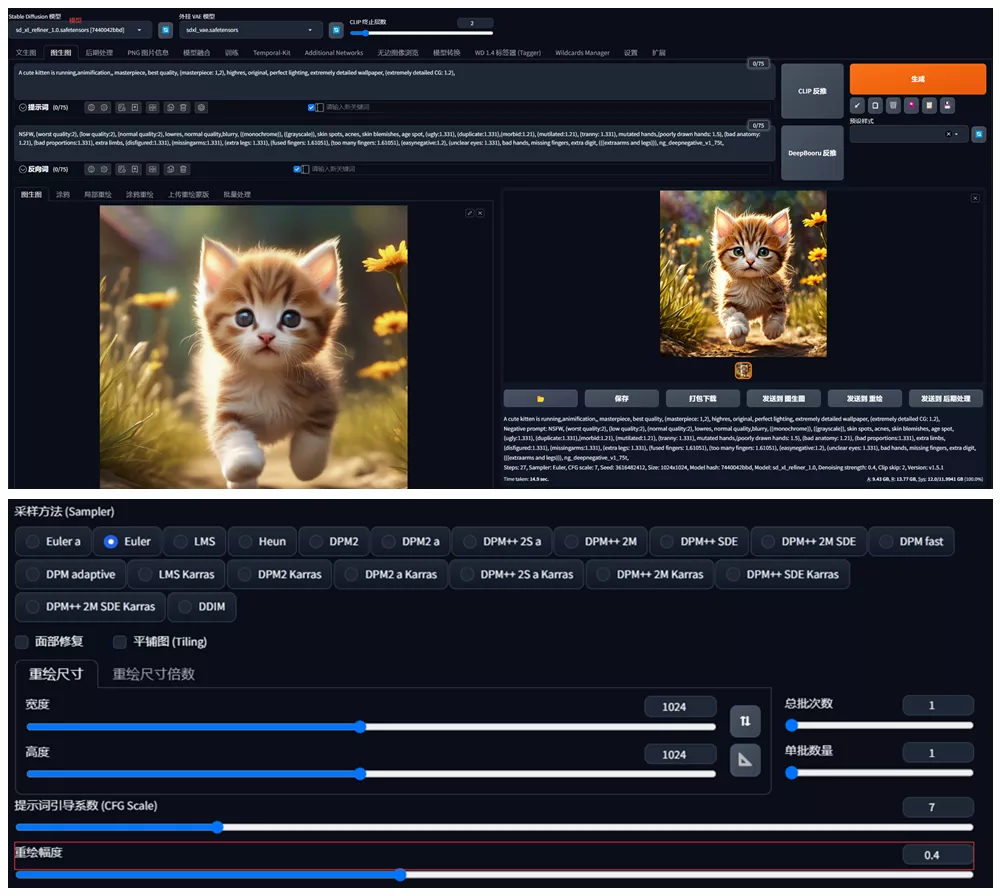

Stable Diffusion web UI

目前最流行的本地 Stable Diffusion应该就是 AUTOMATIC1111 开发的 Stable Diffusion web UI,Stable Diffusion web UI从1.5版就已经支持SDXL 1.0,将下载的模型放入【models\Stable-diffusion】文件夹下,vae放入【models\VAE】文件夹下即可,启动Stable Diffusion web UI后,将文生图界面大模型处选择【sd_xl_base_1.0.safetensors】,vae选择【sdxl_vae.safetensors】,尺寸设置最低为1024X1024,其他方法设置与之前使用其他模型相同,生成图片后,点击【发送到图生图】

开源地址:https://github.com/AUTOMATIC1111/stable-diffusion-webui

在图生图界面将大模型换成【sd_xl_refiner_1.0.safetensors】,重绘幅度处设置小于0.5,其他设置保存不变,点击生成即可。

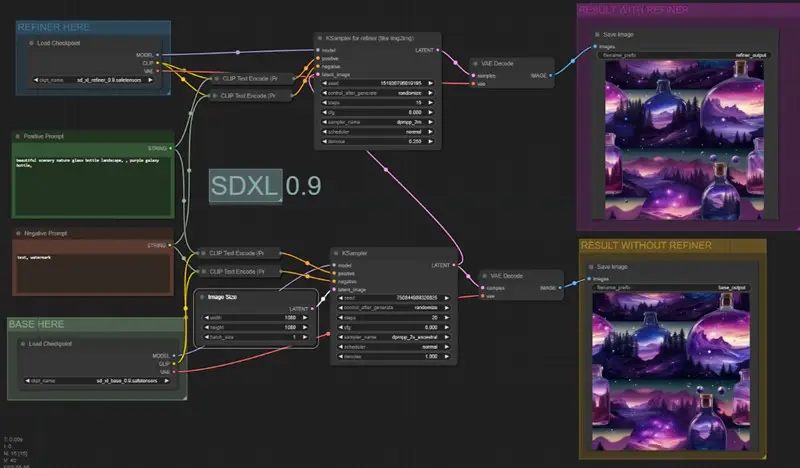

ComfyUI

ComfyUI小编在之前Stable Diffusion XL0.9 模型的时候已经给大家介绍过了,具体下载安装使用可参考:Stable Diffusion XL0.9(SDXL 0.9)本地安装使用教程,简单提示词就能生成精美图片

InvokeAI

InvokeAI号称是面向专业人士的AI绘画工具,其实也就是为 Stable Diffusion 套了一层壳,相比Stable Diffusion web UI,InvokeAI的界面更像官方的DreamStudio,对于插件等支持并不如Stable Diffusion web UI,目前InvokeAI 3.0版本已经支持SDXL 1.0。

开源地址:https://github.com/invoke-ai/InvokeAI

下载地址:https://github.com/invoke-ai/InvokeAI/files/12123253/InvokeAI-installer-v3.0.0.zip

下载InvokeAI 3.0版本解压在一个没有中文字符的路径文件夹下,然后点击【install.bat】进行安装即可,目前InvokeAI 3.0安装下载文件方面,如果你使用国内IP那么就直接从腾讯云下载所需文件,你无需科学上网即可安装

👇在安装到最后需要下载模型的时候需要从GitHub下载文件,你可以直接跳过,后续直接从其他地方下载模型即可

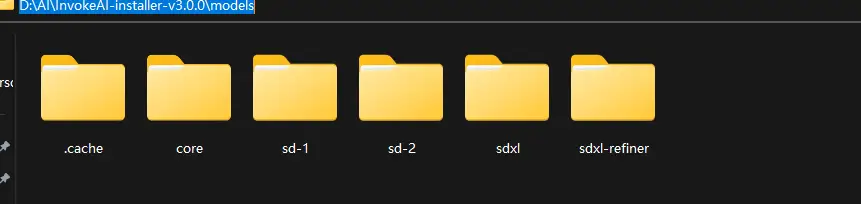

安装完毕后,在文件夹内点击【invoke】即可启动,而下载的模型需要放到【InvokeAI-installer-v3.0.0\models】文件夹内, InvokeAI 3.0比较特别的是它模型文件夹按照Stable Diffusion1.5、2.1和 SDXL进行了分类,根据你下载的模型版本放入即可, SDXL 1.0基础模型放入【models\sdxl\main】内,refiner模型放入【models\sdxl-refiner\main】内

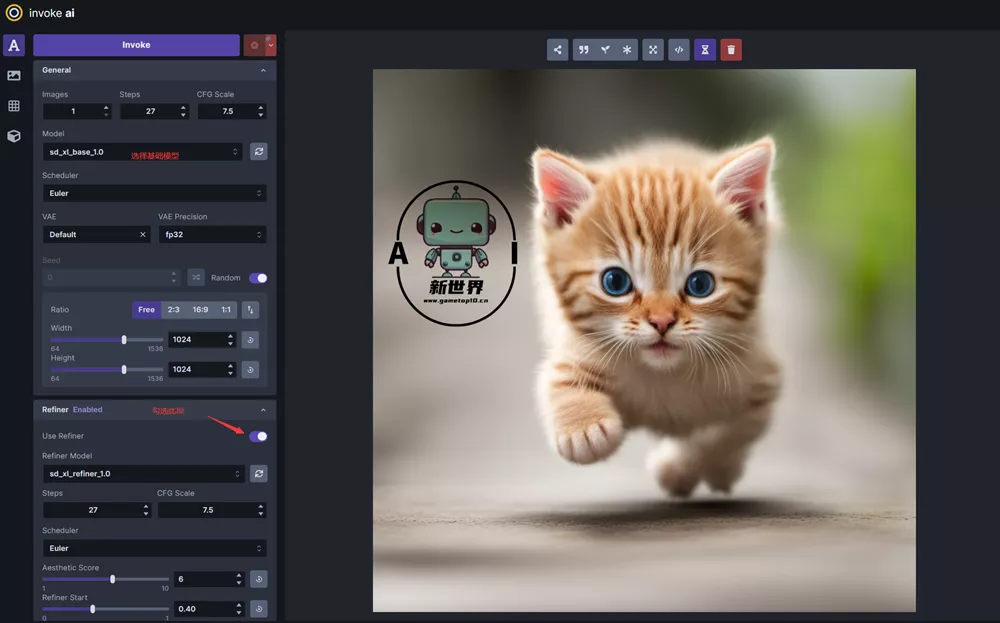

目前支持SDXL 1.0的是3.0.1rc3版本,开启InvokeAI后,填写提示词后选择模型与设置,然后开启 Refiner保持相同设置,降低重绘幅度后即可点击Invoke生成图片。

[t-success icon='']结语[/t-success]

SDXL 1.0在本地运行至少需要8G显存才可以运行,如果你的显卡不行,小编还是建议你使用ClipDrop 和 DreamStudio,而本地运行方面ComfyUI在运行SDXL 1.0效率最高,生成图片所需时间最短,但大家可能使用并不习惯,目前SDXL 1.0对于生成物品、场景和欧美人物较好,对于亚洲人物效果可以说很差,大家还是期待大神们基于SDXL 1.0训练更多针对性的大模型吧!

PS:小编已经将SDXL 1.0模型下载进行了打包上传网盘,扫码关注本站公众号回复“SDXL”即可获取密码。

[password pass='SDXL123' desc='输入密码可见']

https://www.123pan.com/s/I1oZVv-ivuGA.html 提取码:SDXL[/password]