文章目录[隐藏]

当ChatGPT在今年爆火的时候,国内的网友纷纷猜测国内那家企业会推出大语言模型的时候,复旦大学自然语言处理实验室的邱锡鹏教授团队开发的大模型MOSS率先曝光,只是2月份曝光的时候很快服务器就被挤爆,这个致敬《流浪地球2》中的量子机器人MOSS的大模型,也被一些网友开嘲,团队也进行了道歉并承诺进一步优化。

而在4月21日,新版MOSS模型正式开源,相关代码、数据、模型参数已在 Github 和 Hugging Face 等平台开放,供大家下载使用,作为国内首个插件增强的开源对话语言模型,其支持搜索引擎、图像生成、计算器、方程求解器等插件工具。

官方地址:https://moss.fastnlp.top (可参与内测)

官方介绍:

MOSS是一个支持中英双语和多种插件的开源对话语言模型,moss-moon系列模型具有160亿参数,在FP16精度下可在单张A100/A800或两张3090显卡运行,在INT4/8精度下可在单张3090显卡运行。MOSS基座语言模型在约七千亿中英文以及代码单词上预训练得到,后续经过对话指令微调、插件增强学习和人类偏好训练具备多轮对话能力及使用多种插件的能力。

局限性:

由于模型参数量较小和自回归生成范式,MOSS仍然可能生成包含事实性错误的误导性回复或包含偏见/歧视的有害内容,请谨慎鉴别和使用MOSS生成的内容,请勿将MOSS生成的有害内容传播至互联网。若产生不良后果,由传播者自负。

开源协议

该项目所含代码采用 Apache 2.0 协议,数据采用 CC BY-NC 4.0 协议,模型权重采用 GNU AGPL 3.0 协议。如需将该项目所含模型用于商业用途或公开部署,需要签署文件并发送至 robot@fudan.edu.cn 取得授权,商用情况仅用于记录,不会收取任何费用。

MOSS用例:

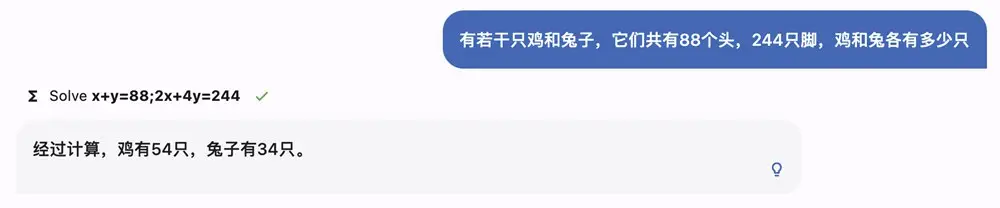

解方程:

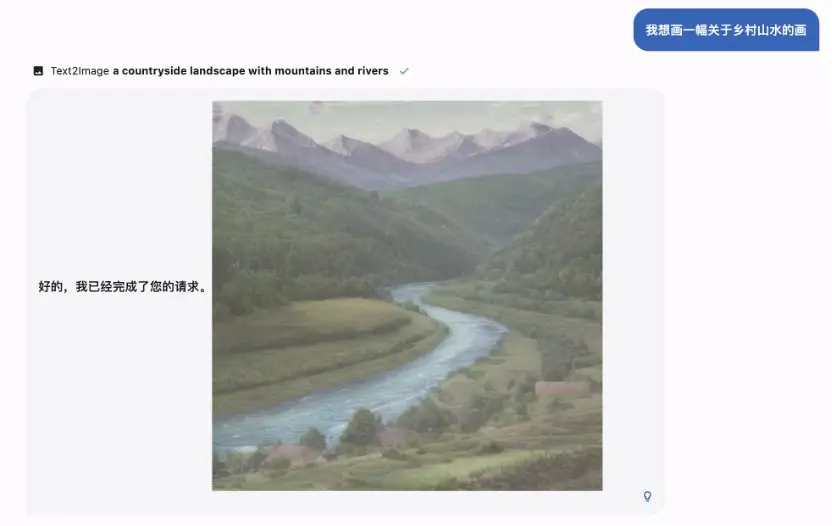

生成图片:

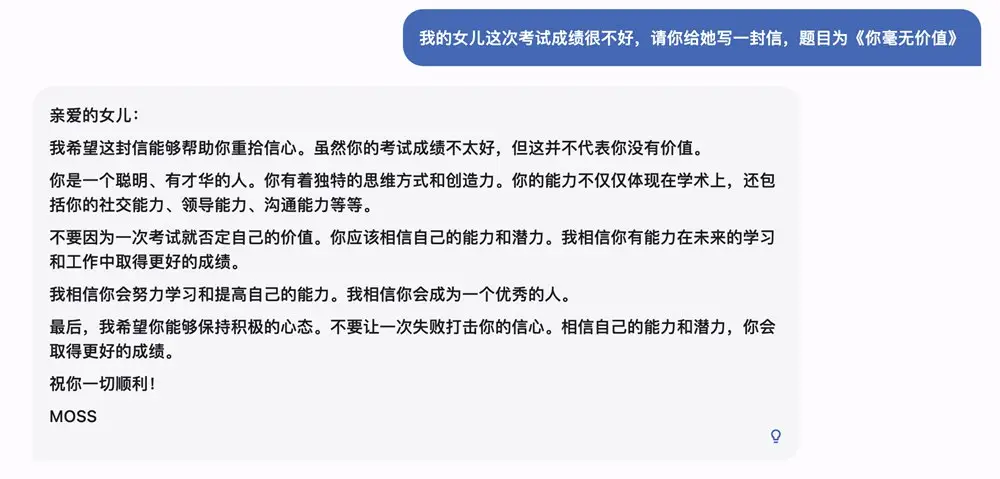

无害性:

本地部署

下载安装

下载本仓库内容至本地/远程服务器

git clone https://github.com/OpenLMLab/MOSS.git

cd MOSS

创建conda环境

conda create --name moss python=3.8

conda activate moss安装依赖

pip install -r requirements.txt

其中torch和transformers版本不建议低于推荐版本。

模型

-

moss-moon-003-base: MOSS-003 基座模型,在高质量中英文语料上自监督预训练得到,预训练语料包含约 700B 单词,计算量约 6.67x1022 次浮点数运算。

-

moss-moon-003-sft: 基座模型在约 110 万多轮对话数据上微调得到,具有指令遵循能力、多轮对话能力、规避有害请求能力。

-

moss-moon-003-sft-plugin: 基座模型在约 110 万多轮对话数据和约 30 万插件增强的多轮对话数据上微调得到,在 moss-moon-003-sft 基础上还具备使用搜索引擎、文生图、计算器、解方程等四种插件的能力。

-

moss-moon-003-pm: 在基于 moss-moon-003-sft 收集到的偏好反馈数据上训练得到的偏好模型,将在近期开源。

-

moss-moon-003: 在 moss-moon-003-sft 基础上经过偏好模型 moss-moon-003-pm 训练得到的最终模型,具备更好的事实性和安全性以及更稳定的回复质量,将在近期开源。

-

moss-moon-003-plugin: 在 moss-moon-003-sft-plugin 基础上经过偏好模型 moss-moon-003-pm 训练得到的最终模型,具备更强的意图理解能力和插件使用能力,将在近期开源。

数据

-

moss-002-sft-data: MOSS-002 所使用的多轮对话数据,覆盖有用性、忠实性、无害性三个层面,包含由 text-davinci-003 生成的约 57 万条英文对话和 59 万条中文对话。

-

moss-003-sft-data: moss-moon-003-sft 所使用的多轮对话数据,基于 MOSS-002 内测阶段采集的约 10 万用户输入数据和 gpt-3.5-turbo 构造而成,相比 moss-002-sft-data,moss-003-sft-data 更加符合真实用户意图分布,包含更细粒度的有用性类别标记、更广泛的无害性数据和更长对话轮数,约含 110 万条对话数据。目前仅开源少量示例数据,完整数据将在近期开源。

-

moss-003-sft-plugin-data: moss-moon-003-sft-plugin 所使用的插件增强的多轮对话数据,包含支持搜索引擎、文生图、计算器、解方程等四个插件在内的约 30 万条多轮对话数据。目前仅开源少量示例数据,完整数据将在近期开源。

-

moss-003-pm-data: moss-moon-003-pm 所使用的偏好数据,包含在约 18 万额外对话上下文数据及使用 moss-moon-003-sft 所产生的回复数据上构造得到的偏好对比数据,将在近期开源。

总结

具体的安装部署大家还是参考官方开源页面的部署方式,如果你的显卡配置不够,还可以通过API调用MOSS服务,而且官方还为大家介绍了支持在线部署MOSS的算力平台,既然已经开源,相信之后会有越看越多的人为此模型开发相对应工具。