文章目录[隐藏]

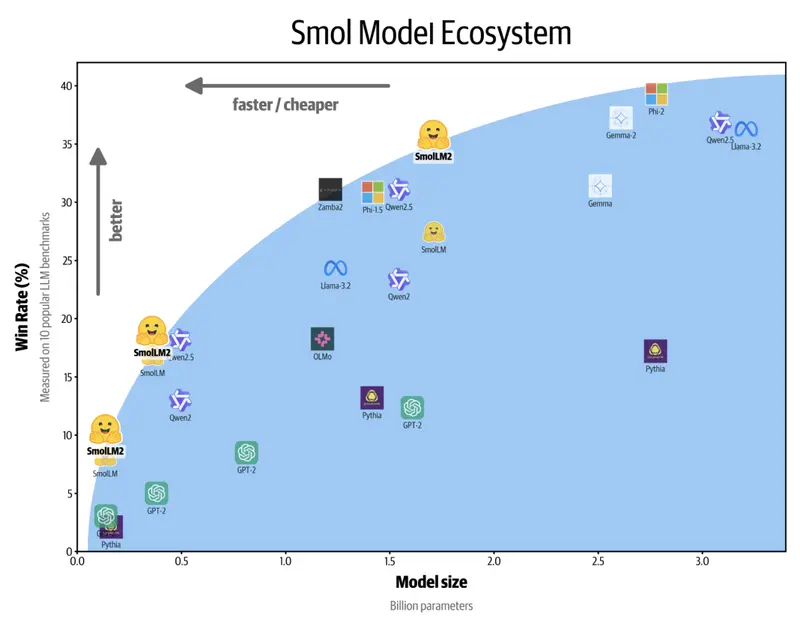

近年来,大语言模型(LLMs)如GPT-4和Meta的LLaMA在自然语言处理(NLP)领域取得了显著进展,但这些模型的资源效率问题也日益凸显。这些模型通常需要大量的计算能力和内存,使得它们在智能手机和边缘设备上的部署变得困难。为了应对这一挑战,Hugging Face推出了SmolLM2——一系列专门为设备上应用优化的小型模型。

模型:https://huggingface.co/collections/HuggingFaceTB/smollm2-6723884218bcda64b34d7db9

SmolLM2的特点

- 紧凑且多功能:

- 模型配置:SmolLM2提供三种配置,分别为0.1B、0.3B和1.7B参数,适用于不同的设备和用例。

- 训练数据:在FineWeb-Edu、DCLM和Stack等数据集的11万亿个标记上进行训练,主要集中在英语文本上。

- 任务优化:每个版本都针对文本重写、摘要和函数调用等任务进行了优化。

- 先进的后训练技术:

- 监督微调(SFT):增强了模型处理复杂指令的能力。

- 直接偏好优化(DPO):提高了模型提供更准确响应的能力。

- 广泛的兼容性:

- 框架支持:与llama.cpp和Transformers.js等框架兼容,可在本地CPU或浏览器环境中高效运行。

- 硬件要求:无需专用GPU,适用于各种设备。

性能表现

- 基准测试:

- IFEval:得分56.7

- MT Bench:得分6.13

- MMLU-Pro:得分19.3

- GMS8k:得分48.2

主要优势

- 设备上运行:

- 低延迟:适合需要实时响应的应用。

- 数据隐私:避免了将数据传输到云端,提高了数据安全性。

- 资源效率:

- 硬件成本:适用于资源有限的设备,降低了硬件需求和能源消耗。

- 灵活性:适用于多种应用场景,包括自动化编码助手和个人AI应用。

- 功能改进:

- 数学推理:相比SmolLM1,SmolLM2在数学推理方面有显著改进,特别是在1.7B参数版本中。

- 函数调用:支持更高级的功能,如函数调用,使其适合需要与现有软件无缝集成的应用。

应用场景

- 边缘设备:

- 智能家居:智能音箱、智能电视等设备上的语音助手。

- 物联网:工业传感器和监控设备的数据处理。

- 移动设备:

- 智能手机:个人助理、翻译应用等。

- 平板电脑:教育应用、笔记应用等。

- 嵌入式系统:

- 汽车:车载信息娱乐系统、自动驾驶辅助系统。

- 医疗设备:便携式医疗设备的数据分析。

结论

SmolLM2的发布标志着在使强大的LLMs对更广泛的设备可访问和实用方面迈出了重要一步。通过提供紧凑且高效的模型,SmolLM2不仅在常见的NLP任务中表现出色,还支持更高级的功能,如函数调用和数学推理。这使得SmolLM2成为边缘AI应用的理想选择,特别是在需要低延迟和数据隐私的场景中。随着小型语言模型在注重隐私和延迟敏感的应用中变得越来越重要,SmolLM2为设备上NLP设定了新标准。