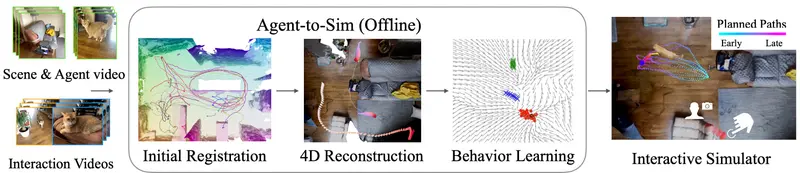

Meta公司与卡内基梅隆大学及加州大学伯克利分校的研究团队共同发布了一项创新成果——Agent-to-Sim (ATS) 框架。这一框架旨在通过分析长时间连续录制的视频资料,自动学习并构建三维空间内生物体(如动物或人类)的行为模型。不同于以往需要标记追踪或使用多角度摄像设备的方法,ATS技术能够在较为自然的状态下,仅依靠单一环境中的视频记录,捕捉并理解目标对象的真实活动模式。

技术亮点

- 非侵入式采集:无需特殊设备或标记,利用普通摄像头长期记录即可获取所需数据。

- 时空精准定位:采用由粗至精的注册策略,实现对目标及摄像头位置的精确追踪,构建完整的四维时空模型。

- 高效行为建模:基于收集到的四维信息,提取智能体的感官输入与动作输出之间的关联,训练出能够模拟真实行为的算法模型。

主要功能和特点

- 从视频学习行为:ATS能够分析你拍摄的视频,学习动物或人的行为模式。

- 3D追踪:它通过一种特殊的追踪技术,能够在视频中长时间追踪动物或人的3D动作。

- 4D重建:这个技术不仅考虑了3D空间,还加入了时间维度,能够重建出随时间变化的场景、角色和观察者(比如拍摄视频的人)的动态。

- 互动行为模拟:ATS能够模拟出角色对观察者行为的反应,比如宠物猫可能会根据你的移动来决定它是靠近你还是跑开。

工作原理

- 粗到细的注册方法:首先,ATS使用一种从粗到细的方法来追踪视频中的代理人(比如动物)和相机,将它们注册到一个标准的3D空间中。

- 生成模型:然后,它使用从4D重建中查询到的感知和动作数据来训练一个生成模型,这个模型能够模拟代理人的行为。

- 行为推理:ATS通过考虑目标、路径和全身运动来模拟代理人的行为,这些行为是基于代理人的自我感知和过去的行为轨迹来决定的。

应用案例

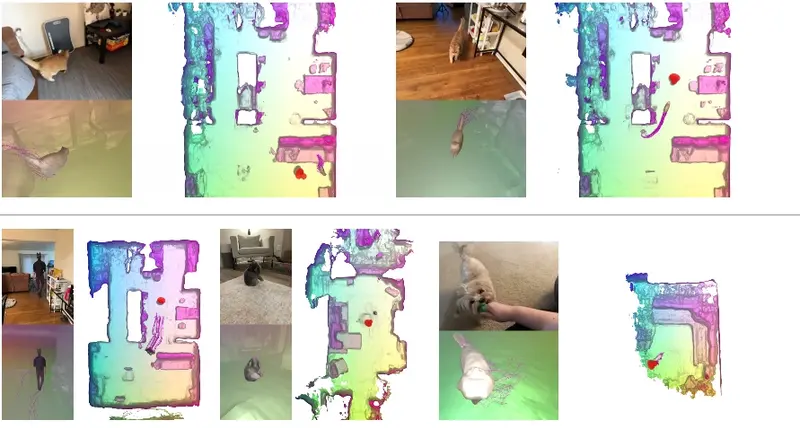

研究团队已经成功将该技术应用于普通智能手机拍摄的单目RGBD视频中,包括家庭宠物(如猫咪、狗狗、兔子等)以及人类个体。这意味着用户只需利用手中的手机,就能轻松记录下宠物或家人的日常生活片段,而ATS框架则可以帮助我们将这些珍贵的记忆转化为可交互的三维数字模型。

具体应用场景

- 虚拟现实(VR)和增强现实(AR):在游戏和娱乐领域,ATS可以用来创建更加真实和互动的虚拟角色。

- 机器人规划:在安全关键的场景中,比如家庭服务机器人,ATS可以帮助机器人更好地理解和预测人的行动,从而做出更好的决策。

- 行为模仿:在电影制作或动画中,ATS可以用于模仿真实世界中的行为,创造更加逼真的动画效果。