目前多数大语言模型的运行都需要配置非常高的GPU服务器来进行训练与运行,即便是已经开源的几个模型本地运行也需要高端显卡才能运行,但目前显卡高昂的价格让很多人望而却步,而现在一款号称集显老电脑、iPhone 手机都能运行开源大语言模型「MLC LLM」已经正式在GitHub上架,完全本地运行无需联网,一起来看看这个项目如何吧!

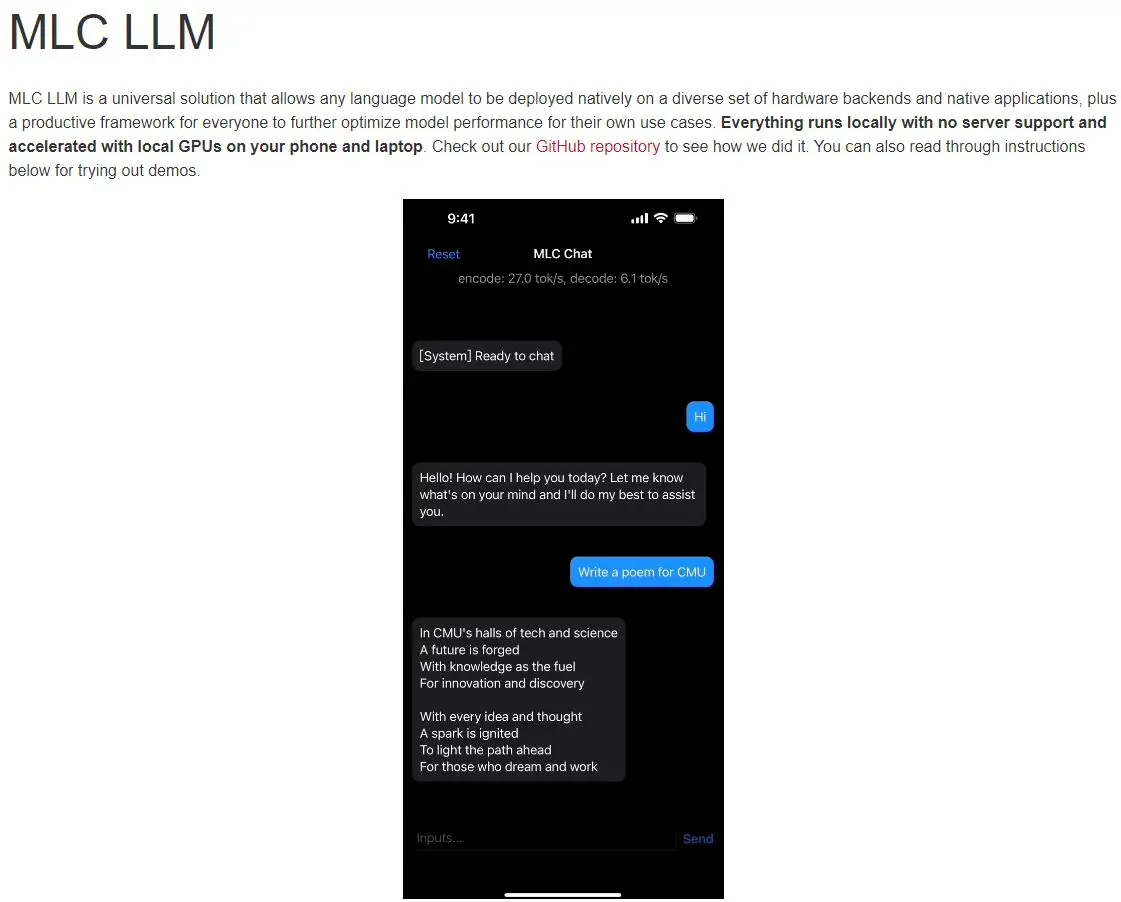

MLC LLM

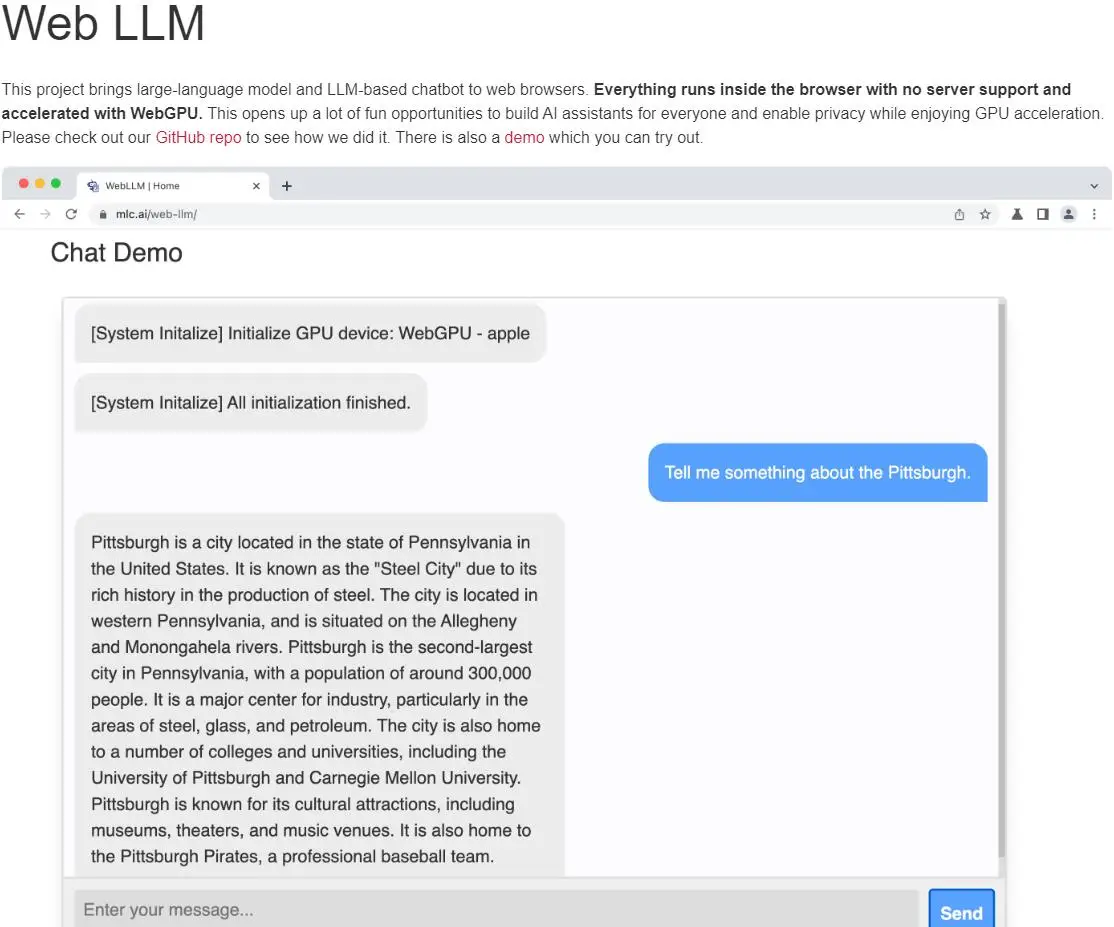

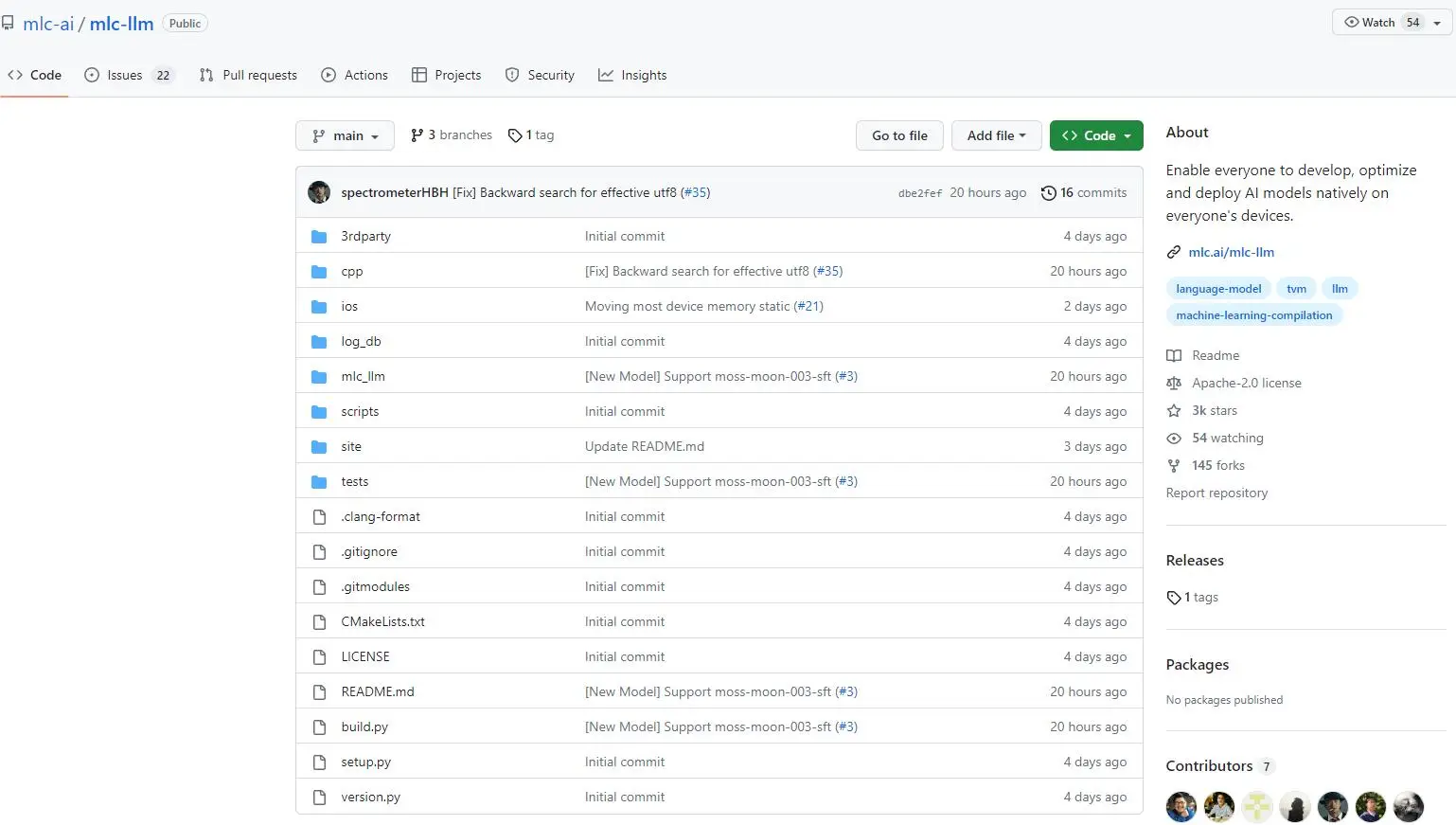

MLC LLM由来自卡内基梅隆大学的 Catalyst 计划、SAMPL 机器学习研究小组以及华盛顿大学、上海交通大学和 OctoML 等开发,之前它们已经推出了无需服务器支持,浏览器就能跑大模型「Web LLM」。

Web LLM体验地址:https://mlc.ai/web-llm

MLC LLM 项目介绍称:“MLC LLM 是一种通用解决方案,它允许将任何语言模型本地部署在一组不同的硬件后端和本地应用程序上,此外还有一个高效的框架,供每个人进一步优化自己用例的模型性能。一切都在本地运行,无需服务器支持,并通过手机和笔记本电脑上的本地 GPU 加速。我们的使命是让每个人都能在设备上本地开发、优化和部署 AI 模型。”

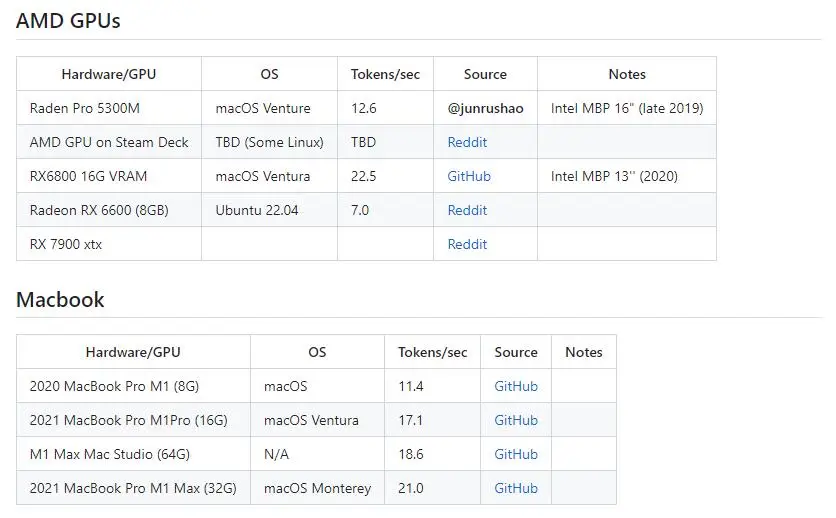

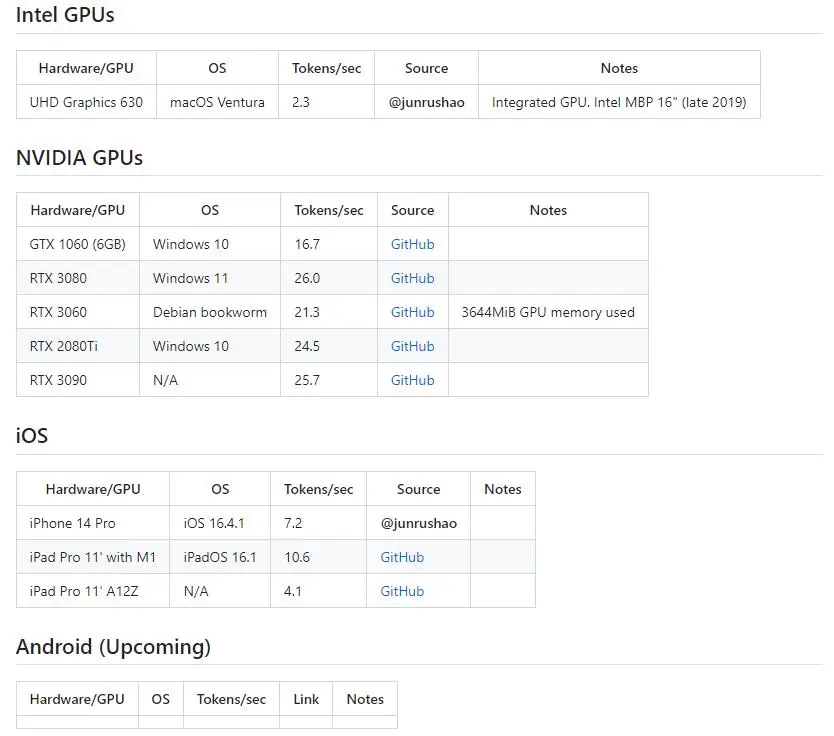

MLC LLM 使用了 Vicuna-7B-V1.1,这是一种基于 Meta 的 LLaMA 的轻量级 LLM,效果不如ChatGPT,但开源就是最大的优势。MLC LLM目前可用于 Windows、Linux、macOS 和 iOS 平台,暂时还没有适用于 Android 的版本。

根据媒体测试结果,6GB 内存的苹果 iPhone 14 Pro Max 和 iPhone 12 Pro Max 手机成功运行了 MLC LLM,安装大小为 3GB;而 4GB 内存的苹果 iPhone 11 Pro Max 无法运行 MLC LLM。目前官方也提供了设备支持状况(点击查看)。

如何安装?

一、iPhone

官方提供了测试版本(仅限前9000个用户),应用需要至少4G内存才能运行,大家也可以下载源码自行编译iOS应用;需要注意的是目前测试应用的文本生成速度不稳定,运行比较慢。

二、Windows/Linux/Mac

MLC LLM 在 PC 平台需要通过命令行运行,媒体测试表现一般,回复时间需要将近 30 秒,而且几乎没有连续对话能力。

在安装CLI(命令行界面)应用程序之前,我们应该先安装一些依赖项:

- 我们使用Conda来管理我们的应用程序,因此我们需要安装一个版本的Conda。我们可以安装Miniconda或Miniforge

- 在Windows和Linux上,聊天机器人应用程序通过Vulkan平台在GPU上运行。对于Windows和Linux用户,请安装最新的Vulkan驱动程序。对于英伟达显卡用户,请确保安装Vulkan驱动程序,因为CUDA驱动程序可能不太好。

![]()

安装所有依赖项后,只需按照安装CLI应用程序下面的说明操作即可:

# 创建一个新的conda环境并激活该环境

conda create -n mlc-chat

conda activate mlc-chat

# 安装Git和Git-LFS,Git-LFS用于下载模型权重

# from Hugging Face.

conda install git git-lfs

# 从Conda安装聊天CLI应用程序

conda install -c mlc-ai -c conda-forge mlc-chat-nightly

# 创建一个目录,并从HuggingFace下载模型权重和二进制库

# from GitHub.

mkdir -p dist

git lfs install

git clone https://huggingface.co/mlc-ai/demo-vicuna-v1-7b-int3 dist/vicuna-v1-7b

git clone https://github.com/mlc-ai/binary-mlc-llm-libs.git dist/lib

# 输入以下命令,开始在电脑上与机器人聊天吧!

mlc_chat_cli三、浏览器

这个就是使用它们的「Web LLM」,可以在浏览器中本地部署模型。所有内容都在浏览器内运行,无需服务器支持,并使用WebGPU进行加速。它们还提供了Web Stable Diffusion模型,让你在浏览器里就可以运行AI绘画应用。以上两种模型都需要WebGPU支持,因此你需要安装Chrome 开发者版本(Canary 版)

Web Stable Diffusion地址:https://mlc.ai/web-stable-diffusion

Chrome 开发者版本(Canary 版):https://www.google.com/chrome/canary

结语:

其实在官方页面对于此模型介绍的都比较清楚了,按照官方的说明按照即可,还有这类以国外为主的AI模型,大家还是使用英语进行测试。