共计 1134 个字符,预计需要花费 3 分钟才能阅读完成。

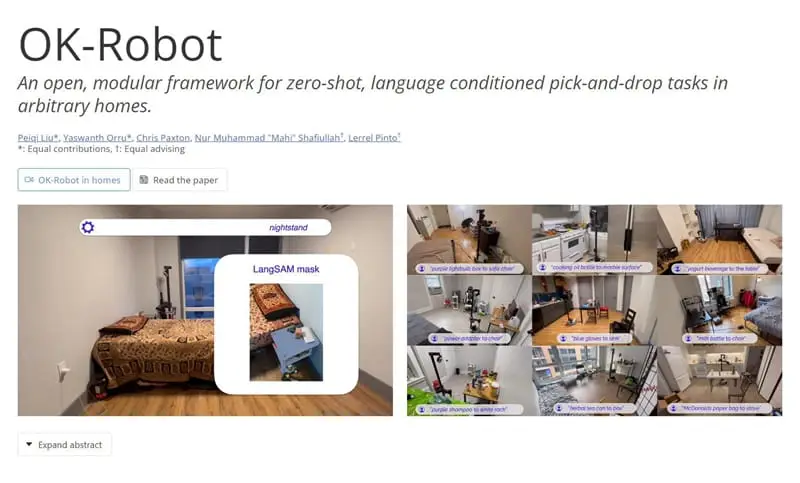

今天,Meta 和纽约大学联合发布新型开放知识型机器人框架 OK-Robot,该框架不需要预训练,就可以在真实家庭环境中运行。经测试,在 10 个真实的家庭环境中运行,OK-Robot 拾取和放置任务的成功率达到 58.5%,如果是干净整洁的环境成功率可以提升到 82%。不过,该系统在现实环境中的表现仍有很大的提升空间,作者们提出了一些可能的研究方向,如实现一个动态的、实时的语义记忆和障碍映射,使用抓取计划而不是仅仅抓取建议,以及提高机器人和用户之间的交互性等。

OK-Robot 系统的核心特点如下:

- 系统架构 :OK-Robot 结合了视觉 - 语言模型(VLMs)进行物体检测、导航原语进行移动以及抓取原语进行物体操作,提供了一个无需训练的集成解决方案,用于执行抓取和放置任务。

- 性能评估 :在 10 个真实家庭环境中运行 OK-Robot,结果显示在开放词汇移动操作(Open Vocabulary Mobile Manipulation, OVMM)任务中,系统在未见过的环境中达到了 58.5% 的成功率,这几乎是之前工作的 1.8 倍。在更干净、整洁的环境中,成功率提高到了 82.4%。

- 关键发现 :OK-Robot 最重要的洞察是,在将开放知识系统(如 VLMs)与机器人模块结合时,细节处理至关重要。实验结果表明,通过改进查询、整理空间和排除明显对抗性物体(过大、过透明、过滑),可以显著提高成功率。

- 技术组件和方法 :

- 开放词汇家庭环境导航 :使用 LangSam 和 CLIP 计算密集的视觉 - 语言表示,并将其存储在语义记忆中。然后,根据语言查询匹配语义记忆,应用导航和抓取原语依次移动到目标物体并抓取。

- 开放词汇 RGB- D 抓取 :在现实世界中,使用预训练的抓取模型(如 AnyGrasp)生成抓取姿势,并使用现代 VLM(如 LangSam)进行语言条件过滤。

- 放置策略 :在抓取物体后,使用与导航模块相同的方法找到放置位置。对于放置位置,系统会考虑物体的类型(如平面、凹面等)并执行相应的放置策略。

- 实验和分析 :通过在不同家庭环境中的实验,研究了 OK-Robot 在新环境中的表现,以及在面对家庭环境中特有的挑战(如杂乱、歧义和可达性问题)时的失败模式。

- 局限性和未来工作 :尽管 OK-Robot 在新环境中展示了零样本泛化能力,但仍存在一些局限性,如静态的语义记忆和障碍物地图、抓取计划而非仅抓取姿势、机器人硬件限制等。未来的研究可以集中在构建动态语义记忆、改进抓取计划、提高用户交互性以及检测和恢复失败等方面。

- 社会影响 :OK-Robot 的技术可能被用于创造性和灵活的内容生成,但同时也存在被滥用的风险,如制作虚假或有害内容。因此,开发和应用检测偏见和恶意使用的工具至关重要。

正文完

关注公众号获取最新教程

发表至:无分类

2024-01-24