共计 343 个字符,预计需要花费 1 分钟才能阅读完成。

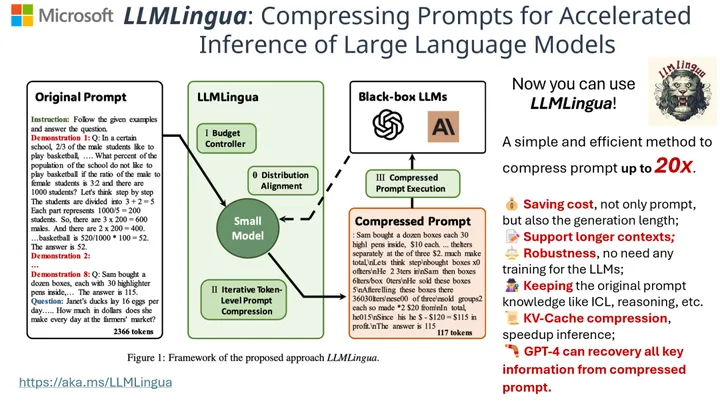

微软的研究团队开发了一种名为 LLMLingua 的独特粗细压缩技术,旨在解决大型语言模型(LLMs)中长提示带来的问题。LLMs 以其强大的泛化和推理能力显著推动了人工智能 (AI) 领域的发展,展示了自然语言处理 (NLP)、自然语言生成(NLG)、计算机视觉等方面的能力。然而,最新的发展,如上下文学习(ICL) 和思维链 (CoT) 提示,导致了部署更长提示的需求,有时甚至超过数万个标记。这在模型推理方面带来了成本效益和计算效率的问题。

GitHub 网址:https://github.com/microsoft/LLMLingua

正文完

关注公众号获取最新教程

发表至:无分类

2024-01-03