文章目录[隐藏]

在科技圈,并非所有大佬的脑洞都值得深究,但 John Carmack 的每一次思考,都能引发行业震动。这位传奇程序员、游戏引擎先驱,近期在X平台抛出了一个极具颠覆性的设想:用一段超长光纤环路,作为AI加速器的L2缓存,专门流式传输AI模型权重,以近零延迟、超大带宽的优势,挑战传统DRAM(内存)的地位——本质上,这就是现代版“延迟线存储”,只不过将传统介质换成了激光与光纤。

核心设想:光纤环路=AI专属L2缓存,靠激光承载海量数据

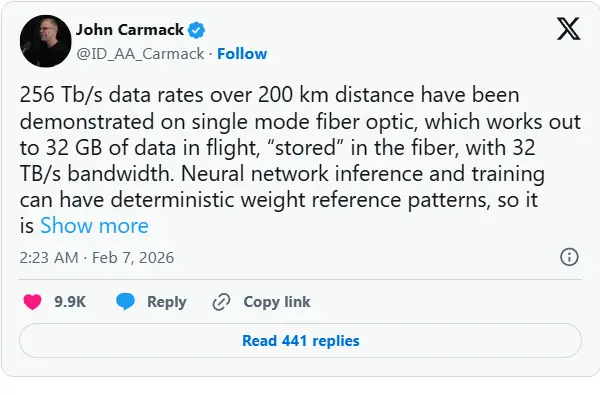

Carmack 的灵感,源于当前单模光纤的技术突破:如今单模光纤的传输速度已达到256 Tb/s,传输距离可轻松覆盖200公里。经过他标志性的“ Doom 机箱背面式粗略计算”(随性却精准的估算方式),得出了一个关键结论:在任意时刻,这段200公里长的光纤电缆本身,就能够“携带”高达32 GB的数据。

这一数据量,恰好适配当前AI模型权重的访问需求——AI模型在推理时,权重需顺序访问,即便在训练场景中,也几乎遵循“顺序读取”的逻辑。基于此,Carmack 进一步延伸思路:

将这段超长光纤环路,打造成AI加速器的专属L2缓存,专门存放并流式传输AI模型权重,确保AI加速器始终处于“数据喂饱”的高效状态;而传统DRAM,则可降级为SSD(固态硬盘)与AI处理器之间的临时缓冲区,甚至未来有望被彻底替代,从根源上优化AI数据传输的效率与成本。

并非全新概念:现代版“延迟线存储”,复刻上世纪科技思路

这一颠覆性设想抛出后,迅速引发行业热议,不少高薪技术从业者纷纷留言,其中一个核心观点戳中关键:Carmack 的想法,本质上是“延迟线存储”的现代复刻版。

延迟线存储技术最早可追溯到上世纪中叶,是计算机早期的一种数据存储方式——当时的工程师们,利用介质传递信号的延迟特性来存储数据,最经典的方案是用水银作为介质,以声波作为数据载体,靠声波在水银中的传播延迟,实现数据的临时存储与读取。

不过,水银的腐蚀性、不稳定性等问题,让这种技术难以实现规模化应用。甚至连图灵(Alan Turing)本人,都曾脑洞大开地提议,用杜松子酒混合物作为延迟线存储的介质,试图解决水银的弊端,可见“用延迟介质存储数据”的思路,早就是科技先驱们探索的方向。

而 Carmack 的创新之处,在于将“延迟介质”从水银、酒精,换成了如今技术成熟、传输效率极高的光纤,将“声波信号”换成了激光信号,让这一古老思路,有了适配AI时代的可行性。

优势与局限并存:节能是核心亮点,成本与技术瓶颈待突破

抛开“脑洞感”,Carmack 的这一设想,并非空中楼阁,其最核心的现实优势,在于极致的功耗节省。

当前,AI服务器的DRAM(内存)是主要的功耗消耗点之一——为了维持内存中的数据不丢失、确保高速访问,DRAM需要持续供电,耗电极高;而光纤传输依赖激光信号,操控光信号的功耗极低,且光信号的传输路径、延迟特性可预测、易处理,这对于追求低功耗、高稳定性的AI算力场景来说,极具吸引力。Carmack 本人也直言:“光纤传输的增长轨迹,可能优于DRAM”。

但与此同时,这一设想也面临诸多现实局限,最突出的就是成本问题:即便不考虑200公里光纤的铺设、维护等物流成本,仅光纤本身的采购成本,就相当高昂,短期内难以实现规模化应用。

此外,行业从业者也指出了其他潜在问题:为了保证200公里光纤的信号强度,需要配备光放大器,同时需用DSP(数字信号处理器)处理光信号,这两者的功耗,可能会侵蚀光纤传输的节能优势;而且随着AI行业的规模化发展,DRAM的价格长期呈下降趋势,其性价比优势仍难以被轻易超越。

甚至有大佬抛出了更“离谱”的延伸设想——Elon Musk 就留言提议,用真空作为光信号的传输介质(也就是“太空激光”方案),试图进一步降低信号衰减,但这种设计的实用性、落地难度,比光纤方案更高,目前仅停留在设想阶段。

更现实的折中路径:闪存直连AI加速器,已有科研团队布局

值得注意的是,Carmack 并非一味沉迷于“脑洞”,他在推文中也暗示了更具现实可行性的折中路径:利用现有的闪存芯片,直接将足够数量的闪存芯片,与AI加速器建立直连,通过精准优化时序问题,替代部分DRAM的功能,实现“低成本、高适配”的AI数据传输方案。

这一方案的核心难点,在于需要闪存厂商与AI加速器厂商,共同制定统一的标准接口,确保闪存与加速器之间的兼容性、传输效率。但 Carmack 认为,鉴于当前AI领域的巨额投入,各大厂商大概率会主动推动接口标准化,这一前景并不遥远。

事实上,这一思路并非Carmack首创,目前已有多个科研团队,探索过类似的技术路径:2021年推出的Behemoth、FlashGNN、FlashNeuron,以及近期的Augmented Memory Grid,都是“用闪存或类光纤介质,优化AI数据存储与传输”的尝试。不难想象,这些方案中,或许有一款或几款,已经进入了实际测试阶段,甚至可能已小范围落地应用。

脑洞背后,是AI算力场景的核心痛点

Carmack 用光纤当L2缓存的设想,看似“天马行空”,实则精准击中了当前AI算力场景的核心痛点——AI模型越来越大,对数据传输的带宽、延迟、功耗要求越来越高,传统DRAM的性能、功耗瓶颈,已逐渐难以适配AI行业的发展速度。

无论光纤缓存的设想,最终能否落地,它都为行业提供了一个全新的思考方向:AI数据存储与传输,未必需要局限于“DRAM+SSD”的传统架构,借助光传输、闪存直连等新技术,或许能找到更高效、更节能的解决方案。而这,也正是大佬们的脑洞价值所在——不追求一蹴而就的落地,而是用颠覆性思考,推动行业突破认知边界。

发表回复