文章目录[隐藏]

上海人工智能实验室发布InternLM3,即书生·浦语大模型第3代,开源了80亿参数,面向通用使用与高阶推理的指令模型(InternLM3-8B-Instruct)。模型具备以下特点:

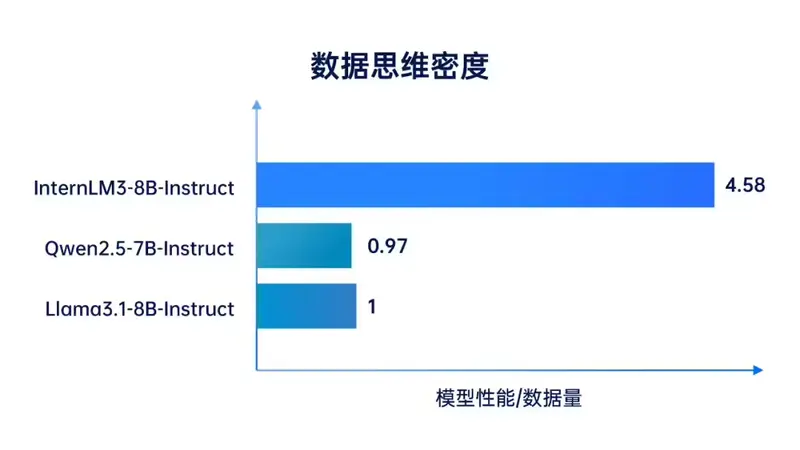

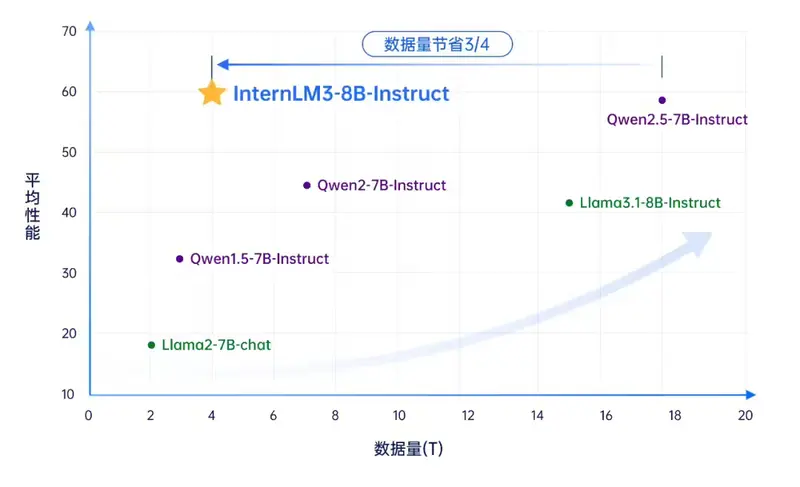

- 更低的代价取得更高的性能: 在推理、知识类任务上取得同量级最优性能,超过Llama3.1-8B和Qwen2.5-7B。值得关注的是InternLM3只用了4万亿词元进行训练,对比同级别模型训练成本节省75%以上。

- 深度思考能力: InternLM3支持通过长思维链求解复杂推理任务的深度思考模式,同时还兼顾了用户体验更流畅的通用回复模式。

InternLM3-8B-Instruct 仅使用 4T 数据训练,官方宣称其综合性能超过同量级开源模型,节约超 75% 训练成本;首次在通用模型中实现了常规对话与深度思考能力融合,可应对更多真实使用场景。

- 官网:https://internlm-chat.intern-ai.org.cn

- GitHub:https://github.com/InternLM/InternLM

- 模型:Hugging Face/ModelScope

InternLM3-8B-Instruct 性能评估

基于司南 OpenCompass 开源评测框架,该模型研究团队使用统一可复现的方法对该模型进行评测。评测采用 CMMLU、GPQA 等十多个权威评测集,维度包括推理、数学、编程、指令跟随、长文本、对话及综合表现等多方面性能,结果显示,书生・浦语 3.0 在大多数评测集得分领先,综合性能“十分接近 GPT-4o-mini”。