文章目录[隐藏]

多模态大语言模型(MLLMs)在人工智能领域迅速发展,通过整合视觉和语言处理,增强了对不同数据类型的理解和交互。这些模型在图像识别和自然语言理解等任务中表现出色,但在资源受限设备上的适应性面临重大挑战。

- GitHub:https://github.com/OpenGVLab/InternVL/tree/main/internvl_chat/shell/mini_internvl

- Demo:https://internvl.opengvlab.com

为了应对这一问题,来自上海人工智能实验室、清华大学、南京大学、复旦大学、香港中文大学、商汤科技和上海交通大学的研究人员推出了Mini-InternVL——一系列参数范围从1B到4B的轻量级MLLMs,旨在在各种领域中实现高效的多模态理解。

Mini-InternVL的特点

- 轻量化设计:

- 参数量:Mini-InternVL的参数范围从1B到4B,显著低于现有的大型多模态模型。

- 性能保持:尽管参数量减少,Mini-InternVL仍能保持较大多模态模型90%的性能,使其在资源有效且在消费级设备上可访问。

- 强大的视觉编码器:

- InternViT-300M:Mini-InternVL采用了从较大的InternViT-6B模型中提炼出的InternViT-300M视觉编码器,增强了模型的表示能力。

- 跨领域适应:这种视觉编码器允许在减少资源需求的情况下进行有效的跨领域转移。

- 灵活的模型变体:

- Mini-InternVL-1B:10亿参数,适用于资源极其有限的设备。

- Mini-InternVL-2B:20亿参数,提供更好的性能和资源平衡。

- Mini-InternVL-4B:40亿参数,适用于需要更高性能的任务。

- 预训练和调优:

- 语言-图像对齐:模型首先在各种任务的广泛数据集上进行预训练,确保视觉和文本元素的稳健对齐。

- 视觉指令调优:模型随后在多模态任务(如图像字幕生成、图表解释和视觉问答)的特定数据集上进行训练,增强了在现实场景中的适应性和性能。

性能表现

- 基准测试:

- MMBench:Mini-InternVL-4B得分为78.9。

- ChartQA:Mini-InternVL-4B得分为81.5。

- 领域特定任务:在自动驾驶、医学成像和遥感等领域,Mini-InternVL-4B展示了与使用更多资源的模型相当甚至超过的性能。

- 资源效率:

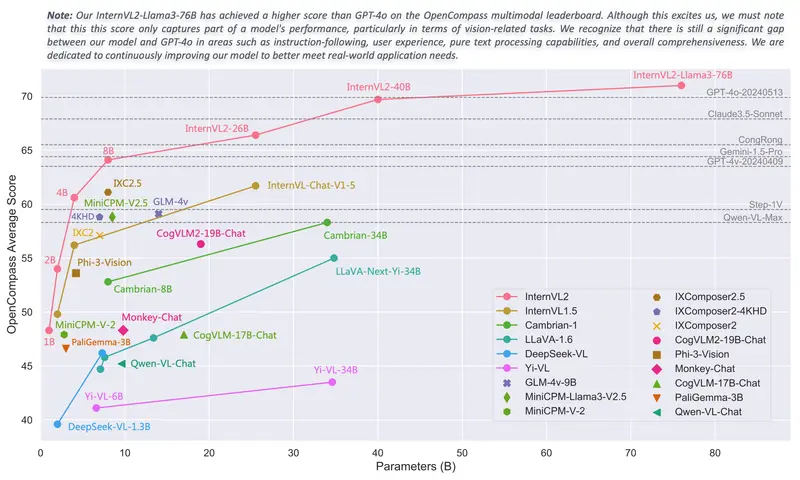

- 参数量对比:Mini-InternVL-4B仅使用了类似InternVL2-Llama3-76B模型5%的参数。

- 计算开销:显著降低了计算开销,使得在消费级设备上部署成为可能。

应用场景

- 自动驾驶:

- 实时感知:Mini-InternVL能够快速处理视觉和文本数据,实现实时感知和决策。

- 资源限制:适用于资源受限的车载系统,提高了系统的效率和可靠性。

- 医学成像:

- 精准诊断:Mini-InternVL在医学图像分析和报告生成中表现出色,有助于提高诊断的准确性和效率。

- 数据隐私:本地处理数据,保护患者隐私。

- 遥感:

- 环境监测:Mini-InternVL能够处理卫星图像和相关文本数据,支持环境监测和灾害评估。

- 实时分析:快速响应和分析,提高决策的速度和准确性。