文章目录[隐藏]

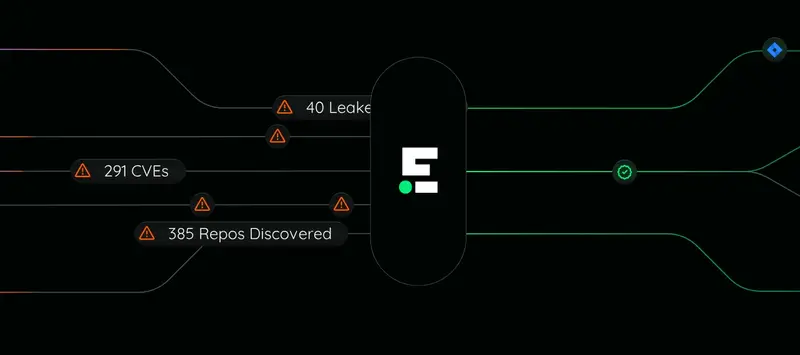

随着AI开发逐渐成熟,类似于开源软件早期的狂野西部时代,模型的构建和使用面临着可见性和安全性的问题。为了帮助开发者更好地理解和评估AI模型,软件供应链安全公司Endor Labs推出了一个新的评分平台——Endor Labs AI模型评分。该平台对Hugging Face上超过90万个开源AI模型进行评分,旨在提高模型的透明度和安全性。

平台概述

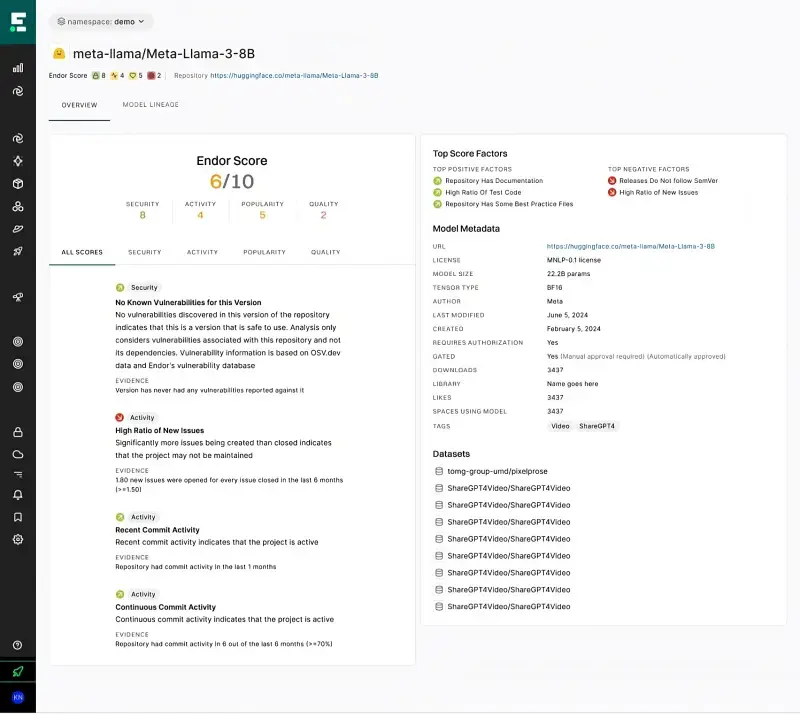

评分标准:

- 安全性:评估模型是否存在潜在的安全漏洞和风险。

- 活动性:检查模型的维护频率和活跃度。

- 质量:评估模型的性能和可靠性。

- 受欢迎程度:衡量模型的使用频率和社区认可度。

评分方法:

- 50个开箱即用的指标:平台使用50个预设指标对模型进行综合评分。

- 自动扫描:平台自动并持续扫描模型更新或更改,确保评分的时效性。

解决的问题

可见性和安全性:

- 黑盒问题:许多AI模型像黑盒子一样,开发者无法了解其内部结构和依赖关系。

- 风险评估:模型容易受到恶意代码注入、域名抢注和用户凭证泄露等风险的影响。

- 透明度:平台提供详细的评分报告,帮助开发者了解模型的安全性和可靠性。

使用场景:

- 模型选择:开发者可以通过平台查询特定任务的最佳模型,例如情感分类、语音识别等。

- 安全性评估:平台提供模型的安全评分,帮助开发者识别潜在的风险。

- 活动性监测:平台跟踪模型的更新频率,帮助开发者选择活跃维护的模型。

技术细节

评分机制:

- 多维度评估:平台基于安全性、活动性、质量和受欢迎程度四个主要类别进行评分。

- 数据解析:使用大型语言模型(LLMs)解析和组织Hugging Face上的数据,确保评分的准确性和全面性。

持续改进:

- 数据收集:随着Endor Labs收集更多数据,评分标准将不断优化和扩展。

- 平台扩展:未来,平台将扩展到Hugging Face以外的其他平台,如OpenAI等商业提供商。

AI开发与开源软件的相似性和差异

相似之处:

- 多种选择:AI开发和开源软件开发都有多种选择,但同时也伴随着众多风险。

- 依赖关系:AI模型通常构建在其他模型之上,形成复杂的依赖图,类似于开源软件中的依赖关系。

差异之处:

- 复杂性:AI模型更复杂,通常由二进制数据组成,评估难度更大。

- 静态性:与频繁更新的开源软件不同,AI模型相对静态,更新频率较低。

- 许可问题:AI模型不仅受许可证管理,还涉及到训练数据集的版权问题,增加了许可的复杂性。

Endor Labs的AI模型评分平台为开发者提供了一个强大的工具,帮助他们在选择和使用AI模型时做出更明智的决策。通过提高模型的透明度和安全性,该平台有望促进AI技术的健康发展,减少潜在的安全风险。随着AI领域的不断发展,这类工具的重要性将日益凸显。