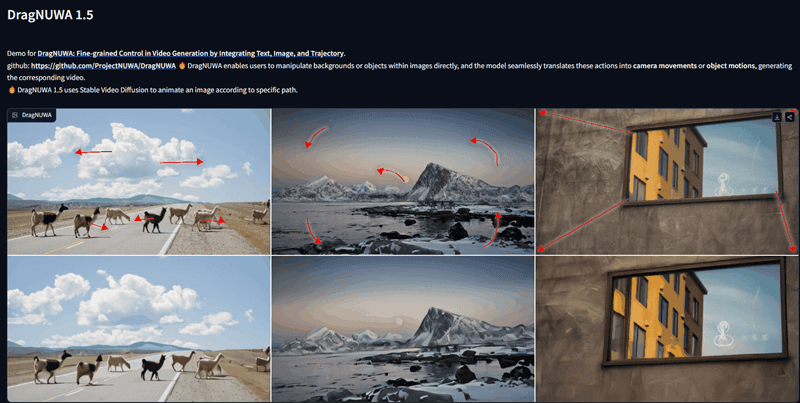

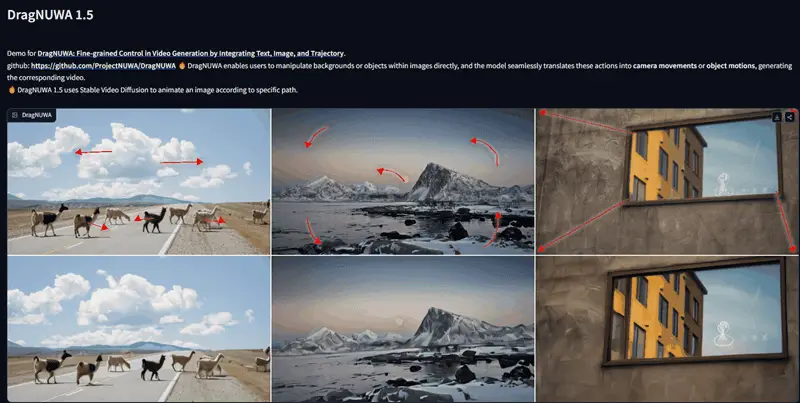

来自中国科学技术大学、微软亚研和北京大学的研究者提出的一种基于开放域扩散的新型视频生成模型DragNUWA,近期更新了1.5版本,还在GitHub上开源了代码,并在Hugging Face与Colab上线了Demo,让大家可以在线体验。这个新版本的功能让用户在通过图像生成视频之前,能够在图像上画出对应方向的箭头标记。用户标记的不是具体的物体,镜头就会按照用户标记的方向运动。用户标记的是具体的物体,这个物体就会按照标记的方向运动。DragNUWA1.5版本的功能可以通过人工智能技术实现,通过识别用户在图像上的标记,自动调整视频画面的运动方向。

项目主页:https://www.microsoft.com/en-us/research/project/dragnuwa

如何使用?

1、通过“Upload Image”按钮上传图像

2、添加控制路径

- 当你想添加一个控制路径时,点击“Add Drag”

- 您可以添加多条控制路径

- 单击“Delete last drag”删除整个最后一次拖动的路径

3、单击"Run"就可开始动画生成

GitHub上开源的项目是运行在Linux上的,大家就不要尝试在Windows上运行了。目前已经有开发者开发出了ComfyUI插件,大家可以在ComfyUI上使用DragNUWA。